Asi funciona la Censura de Facebook

La censura en Facebook es un hecho y son personas, como tú y como yo, las que deciden qué es lo que puedes y no puedes ver en la red social

La censura en Facebook es un hecho y son personas, como tú y como yo, las que deciden qué es lo que puedes y no puedes ver en la red social

Antonio Bret | 26 febrero 2019 |

‘La naranja mecánica’ fue una película de Stanley Kubrick célebre por ser prohibida en numerosos países, debido a sus imágenes violentas y a un mensaje ambiguo que muchos podrían malinterpretar. En ella, un joven ultraviolento es capturado por las autoridades y expuesto a un test para inhibir, en su personalidad, el libre albedrío, es decir, aplicarle un método para convertirlo en buena persona.

¿Cómo lo hacían? mediante un tratamiento de choque: el sujeto es atado frente a una pantalla gigante, con los ojos permanentemente abiertos, y es obligado a ver escenas desagradables horas y horas. Cuando es liberado y siente el impulso de cometer actos violentos, las nauseas le sobrevienen, condicionado por la situación en la que días antes se había encontrado.

ASÍ FUNCIONAN LOS CENTRO DE CENSURA EN FACEBOOK

Ahora, imagina que te dedicas a ver imágenes violentas, desagradables, contenido de odio, insultos, vídeos de decapitaciones… durante ocho horas al día para una gran empresa. Tu trabajo en este centro sirve para determinar qué es lo que otros pueden ver y qué no.

Trabajas para uno de los 20 centros que Facebook tiene dispuestos en el mundo para administrar la censura en relación al contenido prohibido por la red social de Mark Zuckerberg. Eldiario.es ha tenido acceso a fuentes de dichos centros en ciudades como Varsovia o Lisboa, así como a documentos que revelan las condiciones en las que tienen que aplicar la censura dichos agentes.

Según estos documentos, los agentes de la moral y la buena conducta en Facebook tienen que trabajar en unas condiciones deplorables. Oficinas sin ventanas en las que cientos de personas deben, continuamente, fijar la mirada en una pantalla donde se va sucediendo el contenido grotesco para así eliminarlo y que no se expanda.

Son, como Álex en ‘La naranja mecánica’, sujetos expuestos a imágenes terribles durante ocho horas al día sin que se valore, del todo bien, cuáles pueden ser las consecuencias de tal acto. Los algoritmos de los que tanto hablamos no son sino personas, como tú y como yo.

Son, como Álex en ‘La naranja mecánica’, sujetos expuestos a imágenes terribles durante ocho horas al día sin que se valore, del todo bien, cuáles pueden ser las consecuencias de tal acto. Los algoritmos de los que tanto hablamos no son sino personas, como tú y como yo.

SUS CONDICIONES DE TRABAJO FÍSICAS Y MENTALES SON EXTREMAS

Son, en total, 15.000 personas las que trabajan en centros como ese. Muchos de ellos aseguran que es imposible ser justo al 100%, que en las condiciones en las que trabajan, y debido a la naturaleza de la tarea, los fallos pueden sucederse continuamente.

Los trabajadores de la censura en Facebook cobran, cada uno, 700 euros mensuales y están subcontratados a través de consultoras internacionales, estándoles prohibido decirles a nadie que trabajan para Facebook, teniéndose que referir siempre a éste como ‘el cliente. Eldiario.es ha conseguido las declaraciones de tres empleados de este tipo de centros, teniendo que mantener su anonimato.

Los trabajadores de la censura en Facebook cobran, cada uno, 700 euros mensuales y están subcontratados a través de consultoras internacionales, estándoles prohibido decirles a nadie que trabajan para Facebook, teniéndose que referir siempre a éste como ‘el cliente. Eldiario.es ha conseguido las declaraciones de tres empleados de este tipo de centros, teniendo que mantener su anonimato.

Las condiciones de trabajo son extremas. Tienen media hora para descansar en su jornada de ocho horas y tienen que ir administrándolo para, cada hora, tomar pausas visuales, estirar las piernas, ir al baño e, incluso, comer.

En la sala se encuentra, siempre, un revisor que anota y castiga el comportamiento inadecuado: que un empleado se pare, mientras selecciona imágenes, para beber agua o saque el móvil para consultar algo es motivo de sanción. Además, se alienta a los propios empleado, a través de un programa de puntos, a que se acusen los unos a los otros si ven que alguno de sus compañeros realiza alguna conducta sancionable.

En la sala se encuentra, siempre, un revisor que anota y castiga el comportamiento inadecuado: que un empleado se pare, mientras selecciona imágenes, para beber agua o saque el móvil para consultar algo es motivo de sanción. Además, se alienta a los propios empleado, a través de un programa de puntos, a que se acusen los unos a los otros si ven que alguno de sus compañeros realiza alguna conducta sancionable.

El trabajo funciona de la siguiente manera. El empleado tiene frente a él una pantalla donde se van sucediendo todos los contenidos que más denuncias, por parte del usuario, acumulan.

El trabajador tiene, entonces, dos opciones ‘Delete’, con el que borra el contenido, 0 ‘Ignore’, si considera que no está incumpliendo las normas de Facebook. Cada persona puede llegar a analizar hasta 600 casos diarios y tienen, para pulsar uno de los dos botones de decisión, treinta segundos en total para cada uno de ellos. Normal, claro, que lleguen a cometerse injusticias, teniendo en cuenta todo lo que se conoce ahora de estos centros.

El trabajador tiene, entonces, dos opciones ‘Delete’, con el que borra el contenido, 0 ‘Ignore’, si considera que no está incumpliendo las normas de Facebook. Cada persona puede llegar a analizar hasta 600 casos diarios y tienen, para pulsar uno de los dos botones de decisión, treinta segundos en total para cada uno de ellos. Normal, claro, que lleguen a cometerse injusticias, teniendo en cuenta todo lo que se conoce ahora de estos centros.

El periódico pone ejemplos de casos reales en los que han tenido que intervenir los empleados entrevistados. Por ejemplo, les aparecía esta imagen, una ilustración que alerta del cáncer de mama.

Uno de los algoritmos, éste sí automático, que ya ha comenzado a funcionar es el de las imágenes en las que se pueden ver pezones femeninos. Sin embargo, hay excepciones, como en el caso de que las imágenes tengan un carácter divulgativo. Parece evidente que, viendo la ilustración superior, el empleado deba ‘desbloquear’ la imagen ya que se trata de información de interés general acerca del cáncer y no es una imagen de carácter erótico.

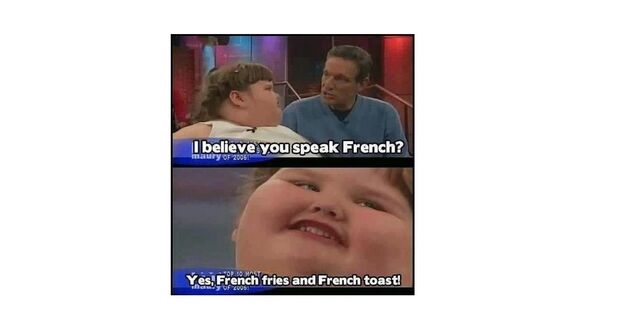

En este otro vemos cómo el trabajo que realizan estos moderadores puede ser tan complicado. ¿Se trata de un meme que supone un acto de acoso infantil? El empleado tiene que decidir, en treinta segundos, si quitarlo o no.

Se trata de una captura de una entrevista real y la obesidad no se considera una incapacidad. En Facebook no se borra nada que pueda ofender a nadie salvo que ese alguien pertenezca a un grupo de discapacitados. En este caso el moderador elegiría el botón de ‘Ignorar’.

Uno de los revisores consultados afirma que el fascismo está permitido en Facebook. Puedes llenar tu muro de fotos de Mussolini que no pasará nada.

Uno de los revisores consultados afirma que el fascismo está permitido en Facebook. Puedes llenar tu muro de fotos de Mussolini que no pasará nada.

Pero cuidado con poner a Hitler. O pezones de mujer.

Se trata de una captura de una entrevista real y la obesidad no se considera una incapacidad. En Facebook no se borra nada que pueda ofender a nadie salvo que ese alguien pertenezca a un grupo de discapacitados. En este caso el moderador elegiría el botón de ‘Ignorar’.

LAS CONTRADICCIONES DE LA CENSURA EN FACEBOOK

Dos ejemplos que pueden ser más o menos claros pero que se encuentran englobados en otros tantos donde la ambigüedad de las normas de Facebook hace acto de aparición. Por ejemplo, el contenido que hace alusión a Hitler es borrado automáticamente. Sin embargo, el contenido en el que se hace apología de Franco está permitido.

Uno de los revisores consultados afirma que el fascismo está permitido en Facebook. Puedes llenar tu muro de fotos de Mussolini que no pasará nada.

Uno de los revisores consultados afirma que el fascismo está permitido en Facebook. Puedes llenar tu muro de fotos de Mussolini que no pasará nada.Pero cuidado con poner a Hitler. O pezones de mujer.

Entre las decisiones más delirantes que tienen que tomar los censores de Facebook se encuentra el considerar el tamaño de la barba de los hombres árabes para ser si son o no terroristas; además, los entrevistados denuncian un claro doble rasero al tener que beneficiar a colectivos específicos.

‘Insultar a unas determinadas creencias está permitido y a otras completamente prohibido‘. Por ejemplo, el sionismo.

Cualquier llamada al boicot de productos de Israel, debido a las matanzas que el país que lleva a cabo en Palestina, son censuradas. Además, la probabilidad de que eliminen contenido en Facebook tiene mucho que ver con el poder y la capacidad de organización que tenga el grupo interesado en que aquel desaparezca.

En el futuro quedará por ver las secuelas psicológicas que tendrán estos empleados de Facebook así como el peculiar uso ideológico que le dan a la moderación de contenido.

No hay comentarios:

Publicar un comentario